신경망 기반의 자연어 처리를 공부하였습니다. ( 최근 동향 )

- 2001 | Neural Language Models

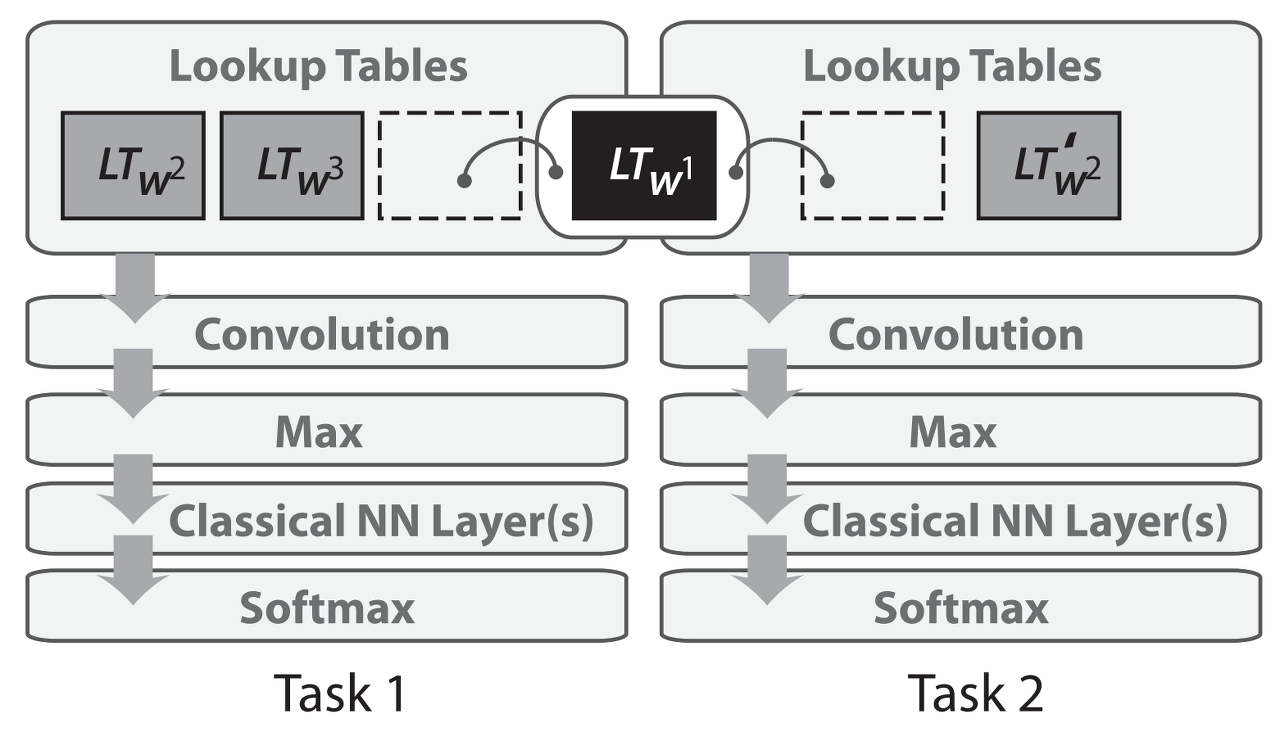

- 2008 | Multi-task Learning

- 2013 | Word Embeddings

- 2013 | Neural networks for NLP

- 2014 | Sequence-to-sequence Models

- 2015 | Attention

- 2015 | Memory-based Networks

- 2018 | Pretrained Language Models

2013 | Neural networks for NLP

텍스트의 Sparse vector 표현, 소위 bag-of-words model은 NLP에서 오랜 역사를 가지고 있습니다. word embeddings의 조밀한 벡터 표현은 2001년에 사용되었습니다. Mikolov et al. 에 의해 2013년에 제안된 hidden layer를 제거함으로써 목표를 근사화하고 이러한 word embeddings를 더 효율적으로 학습하도록 만들었습니다.

이런 변경은 간단했지만 효율적인 word2vec 구현과 함께 word embeddings에 대한 large-scale 학습이 가능하도록 하였습니다.

Word2Vec은 CBOW(Continuous Bag-of Word)와 Skip-gram의 두 가지로 나누어집니다.

이 두 가지는 목적이 다름으로써 차이점이 발생합니다.

1. CBOW

- 주변 단어를 기반으로 중심 단어를 예측

2. Skip-gram

- 중심단어를 기반으로 주변 단어를 예측

이러한 embeddings들은 a feed-forward neural network와 개념적으로 다르지 않지만 매우 큰 말뭉치에 대한 훈련을 통해 성별, 동사 시제, 국가-자본 관계 등을 포착할 수 있습니다.

이러한 관계와 그 이면의 의미는 word embedding에 대한 관심을 촉발시켰고, 많은 연구에서 이러한 선형 관계의 기원을 조사하였습니다. (Arora et al., 2016; Mimno & Thompson, 2017; Antoniak & Mimno, 2018; Wendlandt et al., 2018)

현재의 NLP에서 word embeddings을 강화한 것은 사전 훈련된 embeddings을 초기화로 사용했을 때 광범위한 downstream tasks에서 성능이 향상된다는 점입니다.

word2vec은 직관적이고 마법적인 특정을 가지고 있지만 이후 연구에 따르면 본질적으로 특별한 것은 없다는 사실이 밝혀졌습니다. word embeddings은 matrix factorization을 통해 학습을 할 수도 있습니다. (Pennington et al, 2014; Levy & Goldberg, 2014)

그리고 적절한 튜닝을 통해 SVD 및 LSA와 같은 고전적인 matrix factorization 접근법과 유사한 결과를 얻을 수도 있습니다.(Levy et al., 2015)

그 이후로 word embeddings의 다양한 측면을 탐색하기 위해 많은 연구가 진행되었습니다.

자세히 :ruder.io/word-embeddings-2017/

Word embeddings in 2017: Trends and future directions

Word embeddings are an integral part of current NLP models, but approaches that supersede the original word2vec have not been proposed. This post focuses on the deficiencies of word embeddings and how recent approaches have tried to resolve them.

ruder.io

nlp의 많은 발전에도 불구하고 word2vec은 여전히 인기 있는 선택이며 많이 사용되고 있습니다. 또한, Word2vec의 범위는 단어 수준을 넘어서까지 확장되었습니다. negative sampling을 적용한 skip-gram, local context를 기반으로 한 embeddings 학습, 문장 표현을 학습(Mikolov & Le, 2014; Kiros et al., 2015), NLP를 넘어선 networks(Grover & Leskovec, 2016), biological sequences(Asgari & Mofrad, 2015).

특히 흥미로운 방향 중 하나는 다른 언어의 word embeddings을 동일한 공간에 투영하여(zero-shot) 언어 간 전송을 가능하게 하는 것입니다. 완전한 비지도 방법으로 (유사한 언어의 한해서) 좋은 투영법을 배우는 것이 점점 가능해지고 있으며, 이는 low-resource 언어 및 비지도 기계 번역에 대한 애플리케이션을 엽니다.(Lample et al., 2018; Artetxe et al., 2018)

해당 내용은 사실과 다를 수 있습니다.

정정이 필요한 부분은 댓글로 작성 부탁드립니다. ( 혹은 reference추천도 감사합니다. )

감사합니다.

'Deep Learning > Natural Language Processing' 카테고리의 다른 글

| History of Natural Language Processing(NLP) - Chapter.03 (0) | 2021.03.25 |

|---|---|

| History of Natural Language Processing(NLP) - Chapter.02 (0) | 2021.03.25 |

| History of Natural Language Processing(NLP) - Chapter.01 (0) | 2021.03.25 |